Как воруют деньги с помощью дипфейков и чат-ботов

Дипфейк — технология обработки контента, которая подменяет лицо и голос человека с помощью искусственного интеллекта. Только подумайте: теперь можно посмотреть на актеров в новых ролях или услышать любимого певца, говорящего с нами.

Дипфейки часто встречаются в рекламе, но есть у них и обратная сторона — использование в преступлениях. Например, жертву могут подставить в компрометирующее видео. Или использовать голос в телефонном звонке, чтобы обмануть собеседника и украсть личные данные или деньги.

Воруют деньги не только подделывая личность, но и взламывая чат-ботов в банках. Все это относится к киберпреступлениям. В статье мы расскажем, как преступники используют дипфейки и лазейки в банковских чат-ботах, и дадим советы, как защититься от этих опасностей.

Что такое дипфейк

Термин «дипфейк» появился в 2017 году на интернет-площадке Reddit, а в 2020-м уже официально попал в словари.

Слово deepfake раскрывает принцип действия: это слова deep (сокращение от deep machine learning — умное машинное обучение) и fake (подделка). Дипфейком может быть видео или аудио.

Эта технология выглядит необычно и интересно. Например, в рекламе: в 2020-м СберБанк запустил серию роликов с Жоржем Милославским — героем фильма «Иван Васильевич меняет профессию». А в 2021-м «МегаФон» показали рекламу с молодым Брюсом Уиллисом. В обоих случаях это были дипфейки.

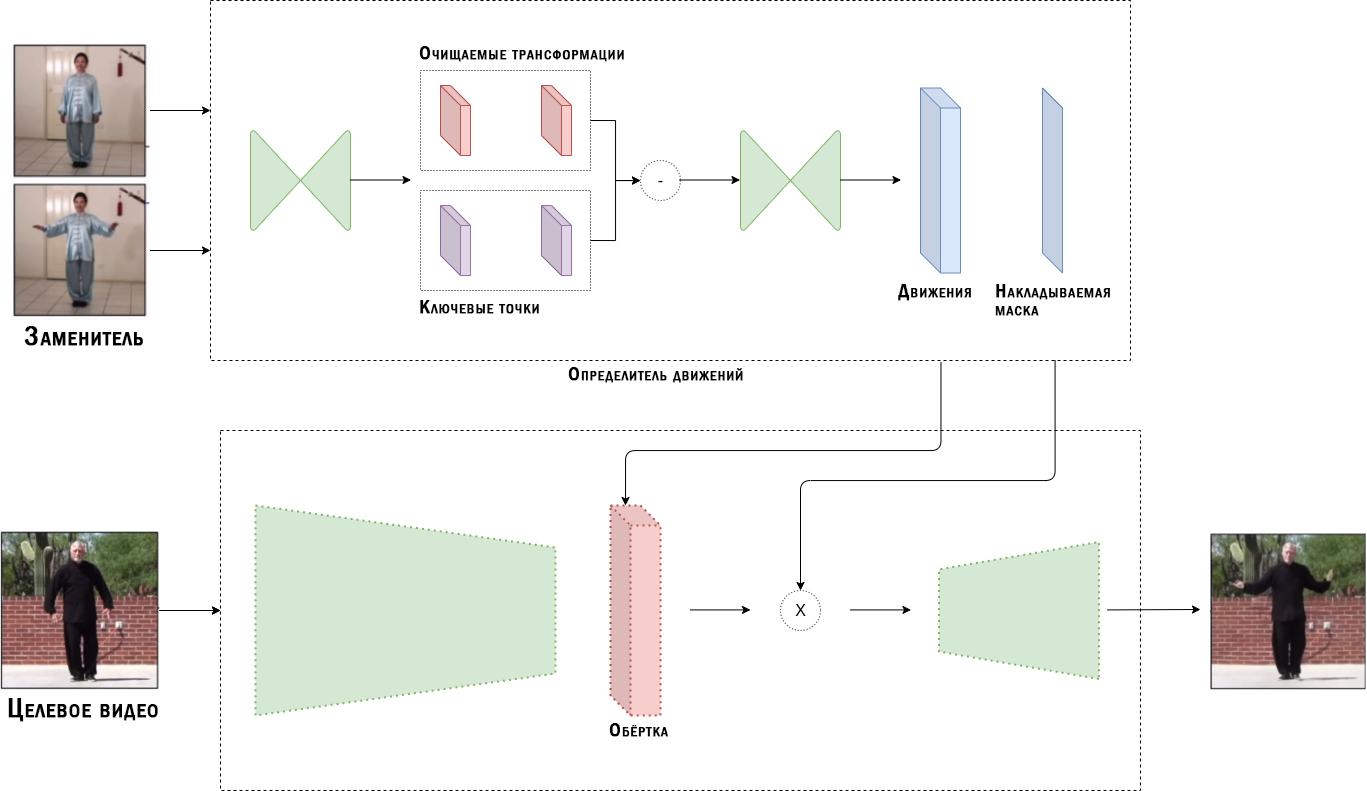

Что нужно для создания дипфейк-видео:

- исходное видео в хорошем качестве;

- фото или видео человека, которого нужно внедрить в дипфейк;

- программное обеспечение для обработки данных.

Схема образования дипфейк-видео с помощью захвата движений с сайта towardsdatascience.com

Для подделки голоса нужен лишь файл-образец и правильное программное обеспечение. ИИ достаточно записи в 10 минут, чтобы воссоздать и синтезировать речь.

Бесплатное ПО Lyrebird AI может воссоздать любой голос с опорой на 10–30 минут аудиозаписи

Ситуация осложняется тем, что уже есть ресурсы, где можно создать дипфейки онлайн без специальных знаний. Например, Deepfakes или мобильное приложение ZAO.

Чем опасны дипфейки

Британские криминалисты признали этот вид киберпреступлений одним из самых опасных на ближайшие 15 лет. Это подтвердила собранная ими группа специалистов по искусственному интеллекту, которая определила три группы преступлений с использованием ИИ:

- самые опасные: дипфейки, взлом беспилотных машин и систем под управлением ИИ, подделка новостей и шантаж;

- средней опасности: анализ систем безопасности и истории действий в сети для дальнейшей продажи;

- наименее опасные: проникновение в дом с помощью управляемых роботов через двери для животных.

Ситуация с подделкой видео настолько серьезная, что в 2018-м Конгресс США выпустил «Акт о запрете злонамеренного использования дипфейков».

Эксперты из Университетского колледжа Лондона считают, что со временем дипфейки будут становиться все качественнее. Преступники смогут применять их, чтобы дискредитировать известных людей и вымогать деньги у жертв, притворяясь их родственниками по видеозвонку.

Как воруют деньги с помощью ИИ

Уже зарегистрировано несколько крупных преступлений, совершенных с помощью ИИ. Во всех случаях преступники подделывали голоса начальников компаний и требовали с подчиненных перевести крупные суммы денег на сторонние счета. Убытки исчисляются миллионами долларов, но лишь один случай получил огласку.

В 2019-м сотрудник британской энергетической компании получил звонок от начальника, в котором тот поручил вывести 220 000 евро на счет другой компании. Человек поверил и отправил средства, насторожившись лишь при повторном звонке «директора», когда тот потребовал перевести еще одну сумму.

Расследование показало, что преступники воссоздали голос руководителя компании, подделав не только интонации и темп речи, но даже немецкий акцент.

Системы воссоздания голоса появились из лучших побуждений. Например, чтобы немые люди могли печатать текст и тем самым «говорить». Теперь же, когда эти системы используют мошенники, IT-компании вынуждены создавать ресурсы, которые анализируют аудио и определяют, реальная это запись или подделка.

Как защититься от дипфейков

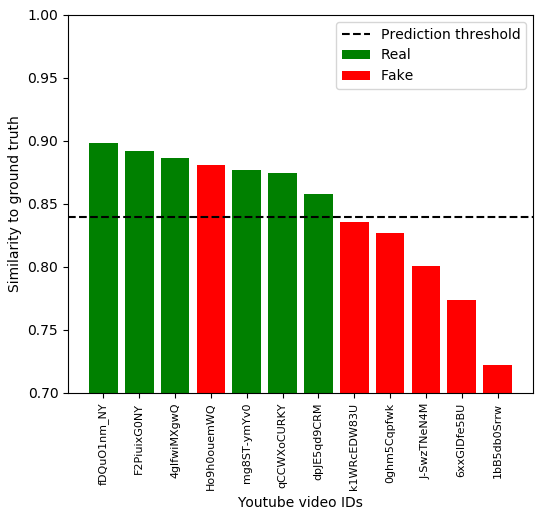

Существует программное обеспечение, которое умеет сравнивать голоса и определять, настоящие они или нет. Например, Resemblyzer от компании Resemble. Главный минус — такие программы работают только с готовым видео или аудио. Они не умеют анализировать голос во время телефонного звонка.

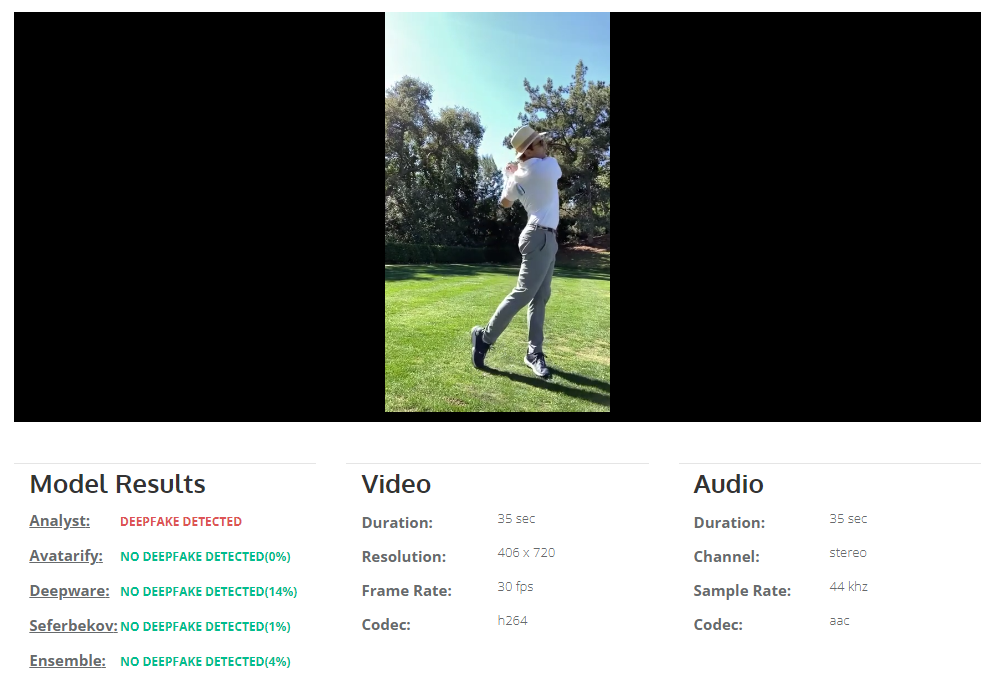

Пример программы, которая анализирует только видео, — Deepware. Это бесплатное ПО, доступное любому пользователю.

Анализ видеоролика от Deepware. Дипфейк был замечен лишь по одному параметру — настолько хорошая оказалась подделка

Кроме того, Google активно содействует созданию ПО, которое определяет дипфейки. Для этого компания открыла доступ к тысячам фраз, озвученных их голосовыми ботами. Компания надеется, что это поможет разработать больше решений против голосовых фейков.

Как определить дипфейк без помощи программ

Существует несколько признаков, по которым можно определить поддельное видео. Мы разделили их на четыре группы:

1. Лицо

Блики в глазах не совпадают, сами глаза не двигаются либо двигаются неестественно. Человек не моргает, лицо замирает на доли секунды — это происходит при искусственной склейке кадров.

Сюда же относится сбитая артикуляция, когда дикция дипфейка не соответствует произносимым словам.

2. Эмоции

Лицо не отражает эмоции, которые должны соответствовать речи. Например, человек на видео рассказывает шутку, но с абсолютно серьезным лицом.

3. Поза и движения

Неестественная поза — легкий способ отличить подделку. ИИ больше концентрируется на лице объекта, чем на теле. По этой же причине движения человека могут быть дергаными, отстающими от естественных.

4. Качество картинки

Неестественный тон кожи, освещение, неправильные тени — все это свойственно дипфейкам. Также подделки не смогут точно воссоздать волосы и зубы — чаще всего они будут статичными и размытыми.

Важный критерий — размазанная картинка на стыке головы и шеи. Любой блюр на видео — повод задуматься о его оригинальности.

Размытый кадр в районе подбородка выдает дипфейк в этом видео с Бараком Обамой (18+)

ИИ настолько хорошо учится, что подделку голоса уже невозможно разобрать без помощи вышеупомянутых программ.

Чем поможет естественный «иммунитет»

Оптимистичный прогноз в отношении дипфейков — люди со временем получат к ним «иммунитет». Исследования показали, что человек учится на собственных ошибках. Если показать пользователю слабые места поддельных видео и аудио, спустя несколько попыток он начнет определять фейковый контент.

Это доказала группа ученых из США и Германии. Они давали людям сравнивать похожие картинки, объяснив, как определить отредактированные варианты. По статистике, фейки начинали определять с восьмой попытки.

Такие фотографии давали сравнивать людям во время исследования «Определение человеком машинно отредактированного медиа». Верхний ряд — оригинальные фото, нижний — отредактированные

Важный фактор — ситуации, когда у жертвы нет времени на раздумья. Никакой софт или «иммунитет» не помогут в стрессовых ситуациях, которые создают мошенники. Например, когда человеку звонит «начальник» и срочно требует отправить деньги на счет другой компании.

Как воруют деньги через чат-ботов

Деньгам грозят не только поддельные личности, но и каналы коммуникации с банками — чат-боты. Они становятся все популярнее с каждым годом. Это напрямую связано с тем, что клиенты ожидают от чат-ботов максимально быстрого ответа на свои вопросы.

Статистика от Drift Insider, согласно которой пользователи ежегодно ожидают от чат-ботов все более быстрых ответов

Самые популярные сценарии преступлений с использованием банковских чат-ботов — сбор информации о пользователе, рассылка вредоносных программ и подмена робота на мошенника.

Специалисты по безопасности обнаружили в банковских ботах уязвимости, которые дают доступ к персональным данным клиентов и переписке в чате. Преступники могут:

- узнать номер и срок действия банковской карты;

- получить доступ к балансу счета и номеру телефона;

- подтвердить перевод денег на другой счет, если код подтверждения приходит в чат.

При этом доступ к банковскому чат-боту не даст преступникам полного доступа к лицевому счету жертвы.

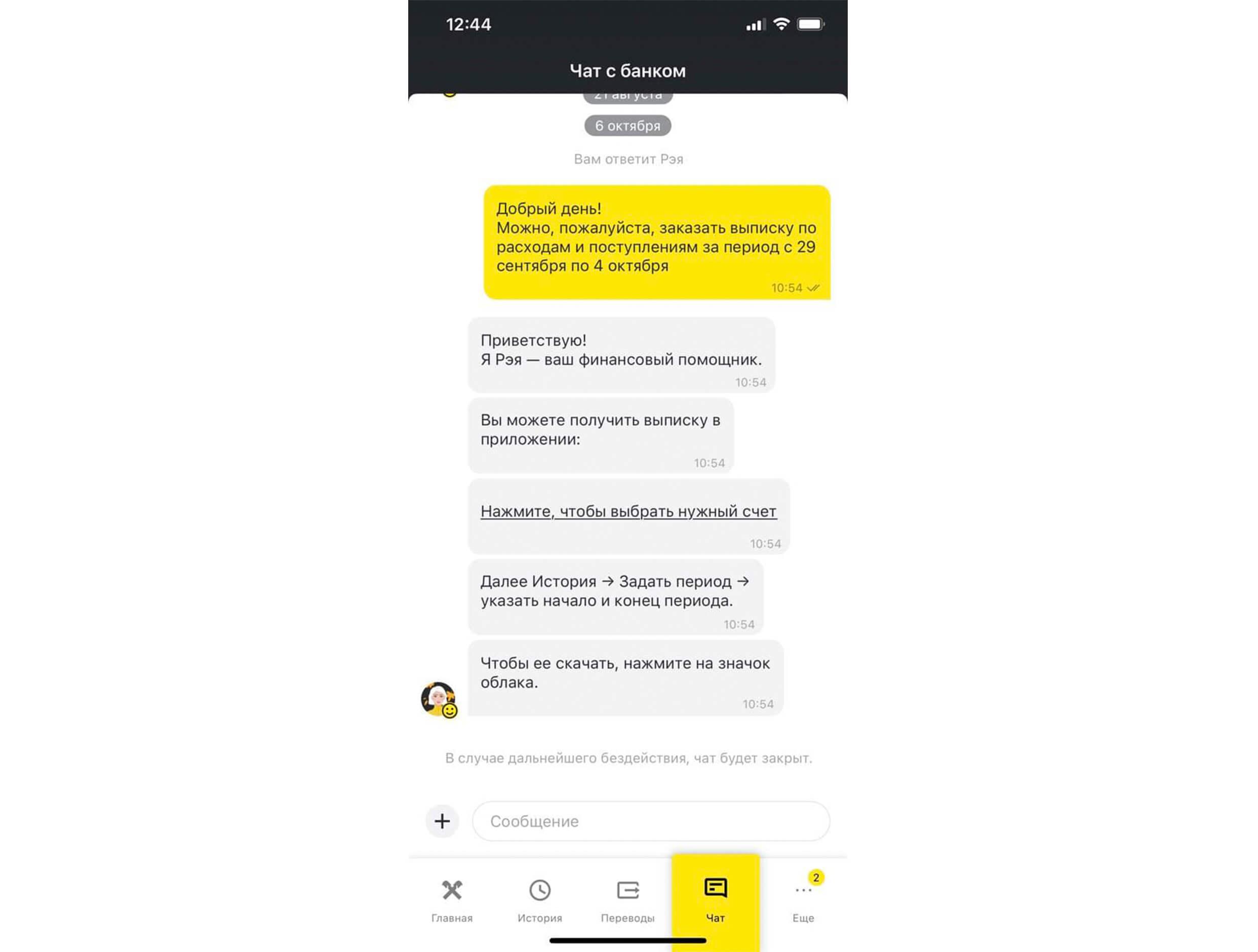

Боты используются в банковских приложениях, мессенджерах, соцсетях и контакт-центрах. Наиболее безопасным считается общение через официальное приложение или личный кабинет на сайте банка, если пользователь прошел в них аутентификацию. Так, Райффайзенбанк разрешает пересылать личную информацию только через эти каналы.

С лета 2021 года бот Райффайзенбанка стал решать 24% клиентских обращений без привлечения операторов. Таких показателей удалось достигнуть благодаря новым механикам обработки текста

Как бороться с лазейками в чат-ботах

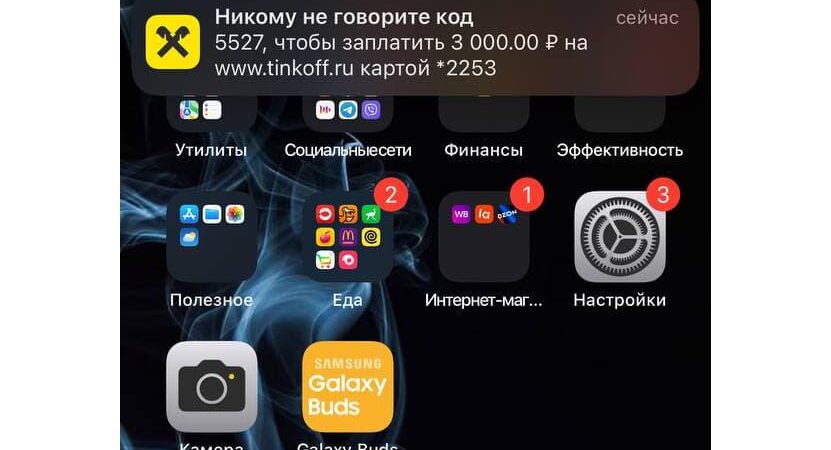

Пользуйтесь двухфакторной аутентификацией. Настройте перевод платежей с дополнительным подтверждением по смс или в пуш-уведомлениях. Тогда взлом чат-бота не поможет мошенникам.

Используйте чат-ботов только в защищенных каналах — официальном приложении банка и личном кабинете на сайте. Бота, настроенного через мессенджер или соцсеть, легче взломать.

Будьте бдительны — насторожитесь, если чат-бот начал запрашивать личную информацию, которую никогда раньше не спрашивал. Возможно, мошенник получил доступ к программе и выдает себя за бота.

Аутентификация платежей через пуш-уведомления Райффайзенбанка

Что важно помнить, чтобы не стать жертвой киберпреступлений

Видео и аудио с дипфейками и взлом чат-ботов — опасный формат киберпреступлений. С их помощью можно выставить человека в дурном свете, испортить репутацию, обмануть и украсть деньги и личные данные.

Чтобы не стать жертвой, будьте внимательны в любых сомнительных ситуациях. Если вас просят перевести деньги или передать личные данные, не торопитесь. Даже если это знакомый голос по телефону или банковский чат-бот. Мошенники часто создают ситуации, когда у жертвы нет времени обдумать действия.

Источник: www.nic.ru/info/blog/

Делитесь с родственниками и друзями !

Related News

СМС c короткого номера FASP

Недавно получил СМС с короткого номера «FASP» на совершенно новый номер телефона, купил месяц назад.Read More